クロールとは?SEOに重要なクローラーのしくみを解説

SEO対策では、検索意図に合致した高品質なコンテンツを作成したとしても、そのページが検索エンジンにクロールされ、インデックスされなければ検索ランキングの対象とはなりません。

さらに、クロールは一度だけではなく、高い頻度で何度もクロールされることで、より正確にインデックスされるようになり、検索評価にもそれが影響します。

つまり、クロールされやすいウェブサイトにすることはSEOではとても重要な要素です。

ここでは、SEOにおけるクロールのしくみや、インデックスの流れ、よりクロールされやすくするための対策、クローラビリティの改善方法について詳しく解説します。

SEOにおけるクロールとは?

SEOでは、クローラーと呼ばれるロボットがウェブページを発見・巡回し、そのページの内容を読み込み、コンテンツや画像・ファイルなどを収集することをクロール、またはクローリングといいます。

また、クロールで収集されたページの内容が、検索エンジン(Google、Bing等)のデータベースに登録されることをインデックスといいます。

ウェブページは検索エンジンにインデックスされなければ検索結果に表示されません。

SEOにおいてクロールされることは必要不可欠であり、いかに最適にクロールされるようにするかが重要です。

インデックスとは?

インデックスとは、ウェブページが検索エンジンのデータベースに登録されることを意味します。

厳密には、検索エンジンがウェブページに記載されたテキスト、画像、動画ファイル等を解析し、検索アルゴリズムに適した状態でデータベースに登録することを指し、この状態をを「インデックスされる」と表現します。

クローラーの種類

クローラーは検索エンジンごとに存在します。

- Googleのクローラー:Googlebot

- Bingのクローラー:Bingbot

- Yahoo!のクローラー:日本ではGooglebot、海外ではBingbot

- 百度(Baidu)のクローラー:Baiduspider

日本においては、Googleが検索エンジンのシェアの大多数を締めており、2番手のYahoo!もGoogleのエンジンを使っているため、Googlebotのしくみを理解しておくことが重要です。

Googlebotとは?

Googlebotとは、Googleのウェブクローラーの総称です。

デスクトップ向けのクローラーと、スマートフォン向けのモバイルクローラーの2種類があります。

Googleは、モバイル向けサイトへの評価をもとに検索ランキングを決めるモバイルファーストインデックス(MFI)を導入しているため、現在は大部分のサイトがスマートフォン用Googlebotでクロールされています。

そのため、ウェブページをモバイルに対応させておくことが欠かせません。

クロールとSEOの関係

SEOでは、まずクロールされることが重要ですが、ウェブページは一度だけクロールされれば終わりではありません。

何度も繰り返しクロールされることで、ページ情報はより正確に検索エンジンに読み取られ、正確にインデックスされていきます。

検索エンジンにとってのクロールのしやすさを「クローラビリティ」といいます。

SEOの内部対策として、このクローラビリティを改善してクロールを促進していくことが大切です。

クロールのしくみと流れ

クローラーはウェブページのリンクをたどって新たにページを発見しながらクロールしていきます。

そのため、クロールされやすくするには最適な内部リンク構造がとても重要です。

しかし、すべてのページをリンクのみで見つけてもらうことは困難です。

新しいサイトや新規公開ページは、見つけてもらいにくいものです。

このような時に最速でクロールされるための対策方法を解説します。

クロールを促進する方法

Googleのクロール技術はとても高く、ほとんどの場合、何も施策しなくても自然にクロールされます。

し かし、自然クロールではクロールされるまである程度の時間がかかってしまいます。

サイトの最新情報を検索結果にいち早く表示させるためには、早くクロールしてもらえるよう施策することも重要です。

コンテンツ公開後すぐにクロールさせるには、以下の2つを必ず行いましょう。

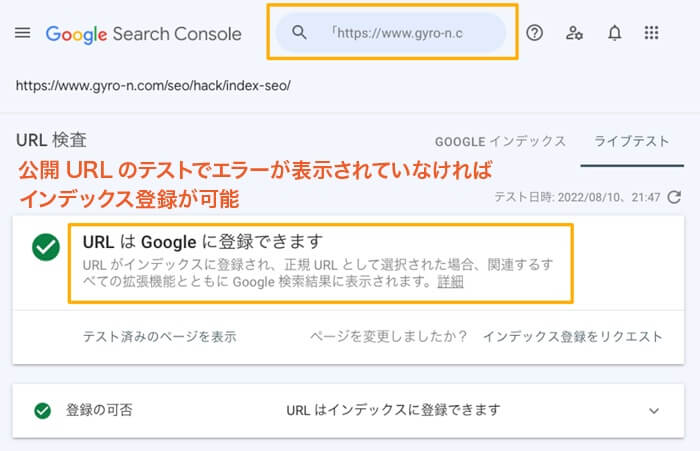

Google Search Consoleからクロールリクエストする

Googleが提供する無料のウェブマスターツール「Google Search Console」のURL検査からクロールをリクエストすることで、スピーディにウェブページをインデックスさせることができます。

URL検査の手順

- サーチコンソールにログインし、対象のプロパティ(ウェブサイト)を選択

- 上部のURL検査入力フィールドにクロールさせたいURLを入力

- 「公開URL」を押し、インデックス登録可能かどうかをテスト

- 検査結果を確認し、エラーなどの問題がなければインデックス登録をリクエスト

インデックス登録をリクエストすると優先クロールキューに追加され、通常よりも早くクロールされます。

通常、リクエストから24時間程度でインデックスは完了する場合が多いですが、サイトによってかかる時間は異なります。

インデックス登録をリクエスト後、数日〜1週間ほど経ってもインデックスされない場合は、別の問題があるかもしれません。

以下の記事を参考に対策してください。

XMLサイトマップを作成する

XMLサイトマップ(sitemap.xml)は、検索エンジンがインデックスすべきURLを見つける手助けになります。

クロールさせたいページを適切に指示するためにこのXMLサイトマップを用意することは、SEO内部対策のひとつとして重要です。

XMLサイトマップはただサイトに設置するだけでなく、検索エンジンにも通知しておくことでより早いクロールを促進できます。

サイトマップの送信方法

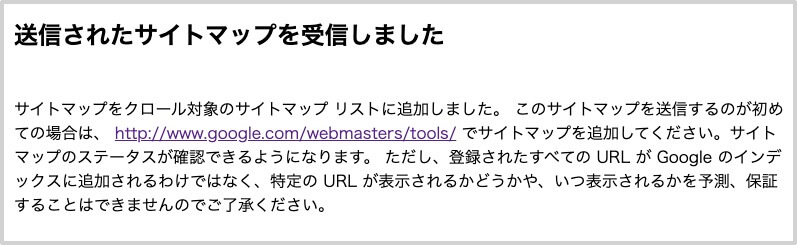

Google Search Consoleの「サイトマップ」からサイトに設置したXMLサイトマップのURLを送信することで、最新のXMLサイトマップをGoogleに読み込ませることができます。

もう1つは、検索エンジンのアドレスバーから直接Ping送信することでXMLサイトマップの情報を検索エンジンに伝えることもできます。

Ping機能を利用したXMLサイトマップの送信方法

「google.com/ping?sitemap=」に続けて、XMLサイトマップのURLを記述してリクエストします。 以下のように受信完了の通知が表示されれば成功です。

クローラビリティを改善するためのポイント

ウェブページをクロールされやすくするには、クローラーにとって優しいウェブサイト構造に設計にしておくことが大切です。

クローラビリティを改善するポイントについて説明します。

パンくずリストを設置する

パンくずリストは、ユーザーに対してウェブページがサイト全体の中でどのディレクトリに位置しているかを伝える役割があります。

検索エンジンのクローラーにとっても、ディレクトリ構造を理解して巡回しやすくすることに役立ちます。

パンくずリストはユーザビリティにおいても、クローラビリティにおいても重要です。

必ず設置しましょう。

内部リンクを適切に設置する

ウェブページのコンテンツ領域から関連するページへ内部リンクを貼ることで、関連度の高いページへのクロールが促進されます。

クローラーはリンクをたどってサイト全体を巡回するため、リンクが緻密に張り巡らされていることでクロール頻度は高まります。

しかし、単純にリンクを貼ればよいというわけではありません。

コンテンツのトピックやテーマが関連しているページ同士がリンクされていることで、クローラビリティが改善されるだけでなく、テーマ性やトピックの強調につながり、検索評価もより高まります。

関連性の低いページへのリンクは逆効果となるため注意してください。

また、クロール頻度の高いトップページやカテゴリトップページからのリンクも、クローラビリティの改善に有効です。

こちらも関連度の高いページへのリンクであることが重要です。

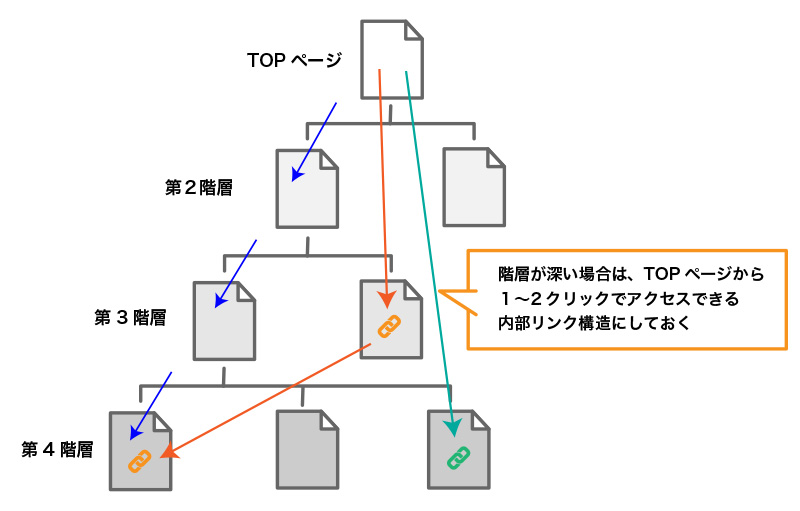

ディレクトリ階層を深くしない

クローラーはリンクをたどってページを発見していくため、階層が深いとページ発見までに時間がかかり、クロールされにくくなります。

できるだけディレクトリ階層は浅い方が、クローラーにも見つけてもらいやすくなります。

ただし、階層が浅いことがSEO評価に直接影響するわけではありません。

また、内部リンクの構造(リンク階層)がしっかり構築されていれば、深い階層でもページは巡回されやすくなります。

もし、どうしてもディレクトリ構造が深くなるサイトを運用する場合は、サイトマップをしっかり設定する、リンク階層が浅くなるよう内部リンクを適切に貼るなどの対策をしましょう。

ページスピードを改善する(読み込みとレンダリング速度を早める)

クロールの対象は、ウェブページのHTMLに書かれているコンテンツだけではありません。

クローラーはCSSやJavaScriptを含め他ページ全体をレンダリングして情報を取得します。

レンダリングとは、HTML、CSS、JavaScriptなどウェブページで利用されているソース情報を、ユーザーがブラウザで閲覧している状態に変換することをいいます。

レンダリングに要する時間はユーザーにとっては表示されるまでの待ち時間であり、「ページスピード」と呼ばれます。

レンダリングに要する時間が長ければ、その分クロールの速度も低下します。

あまりに遅すぎるとクローラーがデータの取得を止めてしまうことも考えられ、インデックスされない原因ともなり得ます。

ページスピードが速ければクロールの速度も向上します。

クローラビリティの改善には、ページスピードの改善も重要です。

また、現在Googleでは「コアウェブバイタル」をランキングの要素として組み込んでいます。

コアウェブバイタルとは?

コアウェブバイタルとは、検索ユーザーの良質な検索体験を評価するための3つの指標を総称したものです。

そのうち、LCP(Largest Contentful Paint)はページ内の最大の要素が表示されるまでの時間、FID(First Input Delay)はボタンやリンクなどユーザーが操作できる要素が読み込まれるまでの時間、という具合に、3指標のうち2つまでがページスピードを軸に評価されます。

このため、ページスピードの高速化は、クローラビリティの改善だけでなく、ユーザーの検索体験(UX)の向上と、そこを評価するGoogleのランキング要素としても重要な施策です。

ウェブページをクロールさせない方法

ほとんどの場合ウェブページはクロールさせる必要がありますが、クロールさせたくないケースもあります。

例えば、会員ユーザー限定のページや、低品質に該当するページ(低品質コンテンツ)、テストページなど、検索ユーザーには必要のないページです。

検索結果に表示させないためにはnoindexを利用して検索対象からの除外をする対応がありますが、そもそもクロール自体をブロックしたい場合は、以下の方法を取ることもできます。

robot.txtを使う

robot.txtは、検索エンジンのクローラーに対して、どのページやディレクトリをクロールするかを制御するためのテキストファイルです。

robot.txtでは、クロール自体を完全に拒否します。

noindexを設定してあるページでもクロールを止めてしまうため、検索エンジンはnoindex自体を検知できません。

そのため、インデックスを制御する目的にはあまり有効ではありませんので、注意して利用してください。

robots.txtの記述例

User-Agent: *

Disallow: /directory-name/ ←ディレクトリ以下のすべてのページをブロック

Disallow: /directory-name/index.html ←特定のページをブロック

Use-Agentは、制御したいクローラーの種類を設定します。

すべてのクローラーを対象とする場合は、*(アスタリスク)を記載します。

Disallowには、クロールをさせたくないページ、ディレクトリをパスで指定します。

ディレクトリ全体をブロックするには対象のディレクトリ名のみを記載し、特定のページのみをブロックする場合はファイル名を含めたすべてのURLパスを記載してください。

また、robot.txtの記述を間違えて、クロールすべきページのURLを記載してしまうなどのミスがあると、重要なページのクロールがブロックされ、一切検索されなくなるなどSEO上の大きな事故につながります。

Search Consoleの「robot.txtテスター」でテストし、細心の注意を払って使用しましょう。

Basic認証を使う

Basic認証(ベーシック認証)とは特定ページやディレクトリにアクセス制限(パスワード認証)をかける方法です。

ページにパスワードを設定すると、検索エンジンはそのページをクロールできなくなります。

basic認証には、「.htaccessファイル」を利用する方法が一般的です。

この方法は手軽にアクセス制限ができますが、セキュリティとしては脆弱なものですので、簡易的なアクセス制限目的の利用にとどめ、重要な情報の保護目的には使わないことをお勧めします。

まとめ

SEOの基本は、検索ユーザーの目的に沿った価値の高いページを作成し、そのページがクロールされ、インデックスされる一連の流れを正しく理解して最適化することです。

クローラビリティの改善は、インデックスや検索評価に影響するため、SEO内部対策のひとつとして非常に重要です。

クロールのしくみをよく理解し、検索エンジンにクロールされやすいウェブサイトにしてください。

![Gyro-n[ジャイロン]](/export/sites/www.gyro-n.com/static/images/logo/gyro-n.png)